Istnieje wiele artykułów poświęconych tematyce MQA, jak również wiele dyskusji wokół przetworników DAC wspierających MQA. Ten artykuł jest naszą próbą ukazania tematu w prosty sposób, dlatego pominęliśmy wiele punktów wzbudzających emocje w dyskusjach o MQA z powodu braku ich jasnego, technicznego wytłumaczenia.

Na początek przyjrzyjmy się MQA. Mówiąc w skrócie, MQA próbuje spakować dużą porcję danych typu audio w rozmiarowo mniejsze pliki za pomocą autorskiego rozwiązania, którym jest „składanie” (ang. folding) danych. Algorytm i poziomy kompresji tego procesu pozostają tajemnicą dla wszystkich, oprócz twórców, więc na teraz zignorujemy kwestie dotyczące rozdzielczości bitowej. Skompresowany plik powinien oferować jakość CD w gabarytowo mniejszym pakunku i może być odtwarzany przez sprzęt/oprogramowanie, które nie wspiera dekodowania MQA. Używając sprzętu/oprogramowania wspierającego MQA jesteśmy w stanie ‘rozłożyć’ (ang. unfold) pliki i potencjalnie odzyskać początkowy plik ‘master’ wysokiej jakości (ang. high-bit rate master file).

Weźmy dla przykładu 192 kHz MQA master. Przy prostych obliczeniach, jedno ‘złożenie’ (ang. fold) zmieni go w plik 96 kHz, a kolejne przerobi go na jakość zbliżoną do CD - 48 kHz. Podobnie 176,4 kHz MQA master ‘złożony’ podwójnie da nam częstotliwość pliku 44,1 kHz.

W przypadku plików 384 kHz lub 352,8 kHz MQA master będzie potrzebne dodatkowe ‘złożenie’. Strona MQA informuje, że pierwsze ‘rozłożenie’ jest procesowane przez MQA Core Decoder, natomiast kolejne ‘rozłożenia’ odbywają się w MQA Renderer. Powody tego mogą być zarówno stricte techniczne jak i użytkowe. Jako że MQA Core Decoder może być zaimplementowany w oprogramowaniu, użytkownicy mogą cieszyć się jakością Hi-Res z plików MQA nawet bez DAC’a z wsparciem dla MQA Renderer. Posiadając jednak taki przetwornik DAC, kolejne ‘rozłożenia’ dają obietnicę nawet wyższej jakości, odpowiedniej do ‘oryginalnego’ pliku master. Powodem, dla którego MQA Renderer nie jest implementowany w warstwie oprogramowania są techniczne ograniczenia, w związku z czym nie będziemy się w to dalej zagłębiać.

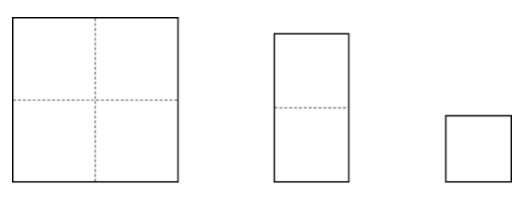

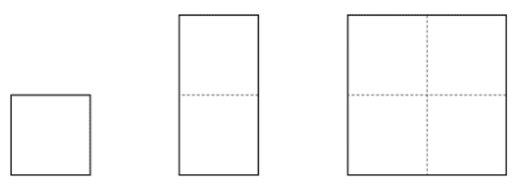

Wiele osób pytało jaka jest różnica (red. w tym procesie) w porównaniu do up-samplingu? Spójrzmy na poniższy diagram.

W tym przypadku, zamiast „rozkładać” plik jego bitrate jest ‘zwielokrotniony’ do pożądanej wielkości, poprzez proces wielokrotnego próbkowania. Jak można zauważyć - aby dotrzeć do większego kwadratu, wystarczy zacząć z tego samego, lecz 4 krotnie mniejszego. Większość up-samplingu jest osiągana przez relatywnie prosty proces ‘ważonej interpolacji’ (ang. weighted interpolation) tj. ’dodawania bitów pośrednich’. Jest to więc mniej skomplikowany proces, w pełni zaimplementowany w różnego rodzaju oprogramowaniu do obróbki i odtwarzania audio, oprócz oczywiście czysto sprzętowej implementacji. Brak w nim skomplikowanego 2-stopniowego procesu.

Na pierwszy rzut oka może się wydawać, że jeśli nie przeszkadza Ci większy (cięższy) plik źródłowy o częstotliwości 44,1 lub 48 kHz, możesz osiągnąć ten sam rezultat (red. jak w przypadku MQA) poprzez up-sampling. Jednak rodzi to pytanie, dlaczego oba wyniki końcowe brzmią inaczej? Argumentem po stronie MQA byłoby to, że zarówno do kompresji jak i dekompresji plików w jakości master używany jest ten sam proces, stąd rezultat jest bardziej spójny. Jednakże, jest też spora szansa, że dobra aproksymacja używana w interpolacji zwiększa gęstość danych, co rezultuje w rozsądnej dokładności. Dodatkowo warto dodać, że MQA odrzuca ‘niesłyszalne’ części danych w procesie ‘składania’.

Czy zatem jedno brzmi lepiej od drugiego? Nie ma na to jednoznacznej odpowiedzi, ponieważ to zagadnienie sprowadza się do indywidualnych preferencji słuchacza.

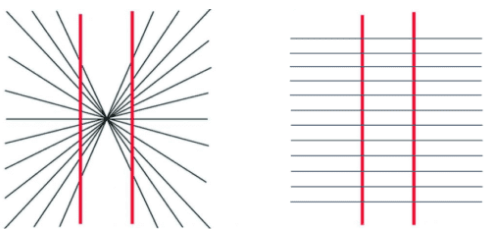

Spójrz na dwa poniższe diagramy.

To dobrze znane złudzenia optyczne wskazują, że nasz umysł postrzega rzeczy w zależności od otaczających je informacji. Stąd straty wynikające z technik kompresji, lub zyski wynikające ze ‘zgadywanych przybliżeń’ (ang. guesstimation) mogą tak naprawdę dążyć do tej samej ‘informacji podstawowej’ (ang. core information). Różnica w procesie dochodzenia do tej informacji może jednak sprawić, że odczuwamy je jako nieco różne w odbiorze. Stąd argumenty, które z podejść jest tym lepszym sprawiają, że rolę zaczynają odgrywać osobiste preferencje słuchacza. Mocnym wskaźnikiem tego jak dużą rolę odgrywają osobiste preferencje są np. testy odsłuchowe z pełnym plikiem Hi-Res (red. porównywanym do ‘regenerowanych’), gdzie część słuchaczy wolała tę nieoryginalną wersję.

Jaka jest w tym rola przetwornika cyfrowo-analogowego? Jak wskazuje nazwa, podstawową rolą DAC’a jest przeprowadzenie konwersji z sygnału cyfrowego do analogowego. Sekcja wejściowa odbiera dane przez różnorodne wejścia cyfrowe i przekazuje je do sekcji DAC. Stąd, logicznym staje się, że decoder/renderer MQA powinien być wbudowany w sekcję wejściową, zanim zdekodowany sygnał cyfrowy jest wysłany do sekcji DAC. Może to się kiedyś zmieni, jeśli nastąpi gwałtowny wzrost użytkowania MQA, przez co producenci DAC’ów będą musieli zintegrować ‘natywne’ dekodowanie MQA. Odkładając jednak ten scenariusz na bok, spróbujmy zrozumieć konieczność posiadania DAC’a zgodnego z MQA.

Wiemy już, że renderer MQA musi być zaimplementowany sprzętowo, więc nie mamy tutaj zbyt dużego wyboru. Jeśli jednak jesteście zainteresowani tylko pierwszym ‘rozłożeniem’ może to być zrobione po stronie oprogramowania, co da możliwość wysyłania 88,2 lub 96 kHz do przetwornika DAC zdolnego obsłużyć te częstotliwości. Typowy komputer PC może nie być najlepszym źródłem, z powodu szumów własnych i innych interferencji. Z drugiej strony PC specjalnie zbudowany jako transport cyfrowy do odtwarzania Tidal Master, sparowany z dobrej jakości przetwornikiem DAC nie wspierającym MQA może być dużo lepszą opcją niż tani, budżetowy streamer/DAC z wsparciem MQA. Podobnie jak w przypadku różnych innych już istniejących formatów oprogramowania i sprzętu audio, jakość źródła multimediów (czyli nagrania) i sprzętu odtwarzającego ma najprawdopodobniej dużo większy wpływ na dźwięk, niż sama technologia.

Źródło: Nuprime